"ב-IT כל עשר עד עשרים שנה לערך יש שינוי מהותי בטכנולוגיה. זה קרה כשמחשבי ה-PC הושקו לראשונה, כשהאינטרנט הגיע ואחר כך ה-WWW, והשינוי המהותי האחרון היה הענן יחד עם הניידות. אני חושב שאנחנו ממש עכשיו בפתחו של עידן חדש, עידן הבינה המלאכותית והוא יימשך הרבה מאוד שנים. יש הרבה מאוד תעשיות כמו נהיגה אוטונומית והדמיה רפואית שזקוקות לבינה מלאכותית, והיא תשפר אותן באופן מהותי, ואנחנו רק מתחילים לחקור את מה שאפשר להשיג בתחומים אחרים, כולל קמעונאות, תקשורת, מכונות ענק שזקוקות לתפעול יעיל ועוד הרבה תחומים אחרים", כך אמר מארק המילטון, מנהל מחלקת הארכיטקטורה וההנדסה של NVIDIA בראיון שנתן בעת ביקור בישראל שנערך לצורך השתתפות בכנס GPU Technology Conference שערכה החברה בישראל, בפעם הראשונה אי פעם.

אם תרצו הכנס הזה הוא הדרך של NVIDIA להראות את החשיבות שהיא מקנה כעת לקידום הצרכים שלה בארץ. זו תקופה בה החברה מרחיבה את המשרד שכבר יש לה כאן, כשהיא במהלך שמטרתו להפוך אותו למרכז מחקר ופיתוח לכל דבר ועניין, בתחום של הבינה המלאכותית והנגזרות הטבעיות שלה כמו למידה עמוקה. "למעשה זו אחת הסיבות העיקריות לכך שערכנו כאן את הכנס כי אנחנו משקיעים כדי להגדיל את המשרד שלנו באופן משמעותי. אנחנו מאמינים שיש פה את הקהילה המתאימה שגם מאוד מתעניינת בנושא, ואפשר היה לראות את זה בכנס העמוס וגם בסדנאות שהעברנו ולא נותר עבורן אפילו מקום אחד פנוי", אמר המליטון.

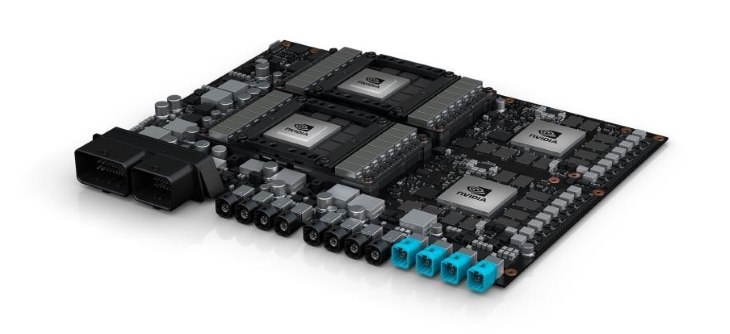

NVIDIA אולי מוכרת יותר בקרב הציבור הרחב כיצרנית של מעבדים גרפיים, וכנראה שיש יותר אנשים שיודעים לומר מתוך שינה GeForce GTX, או משהו כזה, מאשר Drive Px – המערכת של החברה שמיועדת לתחום הנהיגה האוטונומית ומעבר לכך, אבל כבר לפני כמה שנים טובות היא הייתה חברה שדחפה לשימושים מורחבים במעבדי הגרפיים, מה שכונה בעבר 'שבבים גרפיים לצורך שימוש כללי' (General Use Graphic Processor Unit). ההשתלבות שלה בתחום הבינה המלאכותית כנראה היה רק פועל יוצא של המגמה הזו.

לפי המילטון, השילוב של תוכנה עם חומרה הוא מה שמציב את NVIDIA בחזית היצרניות שמציעות את המוצרים שמניעים את שוק הבינה המלאכותית של ימינו. "אנחנו החברה היחידה שמציעה את המעבד, את השפה CUDA, את הספריות המתמטיות. אנחנו לא מכינים את מערכות הלמידה העמוקה עצמן, אבל את הקוד שלנו תמצאו בכל רשת למידה עמוקה ואנחנו עושים את תהליך הסקת המסקנות, ואנחנו עושים גם שרתים ותחנות עבודה, ויש לנו גם אלפי מהנדסים שיושבים ומכינים את כל מה שצריך כדי לבנות את הענן של NVIDIA שמספקים דרכו את כל העדכונים שזקוקים להם עם כל דור חדש של מעבדים. אנחנו בונים את שרתי ה-DGX שלנו וממטבים את המערכת שתפעל היטב עם החומרה שלנו. ואנחנו גם עוזרים לכל החברות שבונות את המערכות שלהן לעצמן, ואם הן פונות ליצרניות אחרות אנחנו אלו שעוזרים לחברות הללו למטב את המערכות הנדרשות על בסיס המעבדים הגרפיים שלנו", הוא סיפר.

הזינוק עכשיו, אבל הבינה המלאכותית כבר מזמן כאן

למרות שהבינה המלאכותית על צורותיה וגווניה עכשיו בכותרות הטכנולוגיות, היא כבר כמה עשרות שנים מסתובבת בסביבה.

"בינה מלאכותית היא תחום רחב מאוד שכבר נמצא בסביבה זמן רב מאוד, ולמידה עמוקה היא קבוצת משנה של בינה מלאכותית. גם תחום זה נמצא בסביבה בערך 40 שנה אבל זה לא עבד טוב כי זו מדובר למעשה בתוכנת מחשב שכותבת תוכנה והיא כותבת זאת על ידי שימוש בהרבה מאוד נתונים", הסביר המילטון. "לדוגמה, אם רוצים ללמד אותה לזהות תמרור עצור או תמונות של חתולים אתה זקוק לפחות לאלפי תמונות ולעתים גם מליוני תמונות שישמשו כדוגמאות שיאפשרו להכשיר את המחשב. לפני 40 שנה פשוט לאף אחד לא היו מליוני דוגמאות כדי לעשות את זה".

אז מה השתנה?

"לפני עשר שנים עם, העליה של האתרים הצרכניים כמו גוגל (Google) ופייסבוק (Facebook) התחלנו לצבור את הכמויות הללו של מליוני תמונות, ונישאר עם חתולים, אבל הבעיה שאז עדיין לא היה מספיק נפח אחסון, והיה צורך בשנה לפחות לתכנן רשת נוירונית והיית צריך לבצע את זה מספר פעמים, אז אף אחד לא ממש היה מעוניין במחקר כי היה צורך בזמן רב כדי להגיע לתוצאות. אבל בערך ב-2012 לקחנו את האלגוריתם הישן הזה של רשת נוירונית ותכנתנו אותו מחדש לשבב הגרפי, ואז הלימוד המעמיק התחיל להמריא".

בתודעה הציבורית בינה מלאכותית ולמידה מעמיקה מקושרים חזק מאוד לאינטרנט של הדברים.

"זה בתלות בהקשר. IoT זה יכול להיות מצלמת האבטחה שנמצאת כאן בחוץ, וזה לא ממש מכשיר שרק יכול לצלם תמונות אלא משהו שאפשר לאמן לצורך ביצוע של למידה מעמיקה. עוד סוג של IoT זה חיישנים קטנים שיכולים לבדוק דבר מסוים כמו מזג אוויר, וזה יותר לימוד מעמיק מאשר ביג דטה, כי אם אתה משרטט גרף של שינוי הטמפרטורה לאורך היום זה אולי מבחינת המחשב אוסף של 1 ו-0, אבל זה בעצם זה סוג של תמונה. אז אם יש מליוני חמונות כאלה שצריך לנתח ולכאורה אין מספיק כוח מחשוב עולם כדי להבין כל תרחיש שיכול להתרחש אבל בלימוד מעמיק שמזהה תמונות כן אפשר להגיע למסקנות, וכך הבינה המלאכותית כן יכולה לכתוב את התוכנה שתבצע את העבודה הזו".

כלומר את מדבר על עתיד בו התוכנות יכתבו את התוכנות שצריך באופן אוטומטי.

"זה למעשה קורה כבר כיום. כשאתה מעלה תמונה לפייסבוק והרשת מזהה שהחתול שלך נמצא שם, אז זו תוכנית שלא נכתבה בידי בן אדם אלא בידי תוכנית בינה מלאכותית שמשתמשת בלימוד מעמיק".

אני מתחיל לפחד כבר עכשיו.

"אני לא חושב שיש צורך כי מה שתוכנות בינה מלאכותית יכולות לעשות זה לא בדיוק דברים שאני ואתה מגדירים כבינה או כבינה יצירתית, זה בסך הכל מסתכם כיום בזיהוי תבניות מתוך הרבה מאוד דוגמאות. אפשר לומר בעצם שלימוד מעמיק זה בעצם יותר ללמוד לזהות מאשר ממש ללמוד. מחשבים יותר חכמים מבני אדם? אנחנו נמצאים במרחק של עשרות שנים משם אם בכלל. אני לא חושב שאפשר לומר שמחשבים יכתבו תוכניות מחשב שיהיו ממש יותר חכמות מבני אדם. כלומר בינה מלאכותית יכולה ליצור, לדוגמה, תוכנית שתזהה 20,000 סוגים של צמחים. אני בקושי יכול לזהות שניים. אז כן אפשר אולי לאמן מחשבים להיות חכמים מבני אדם אבל בתחומים מאוד מאוד צרים ומוגדרים ולא בהיבט הרחב".

ניתן למנוע שימוש לרעה?

"אנחנו לא יכולים למנוע שימוש לרעה בבינה מלאכותית אבל אנחנו מאמינים שבכך שאנחנו מציעים את מה שיש לנו באופן פתוח ושקוף, אנחנו פועלים לטובת הכלל ולקידום הצרכים שלנו באופן גלובלי".

הבינה המלאכותית מוכנה לשנות את החיים

יש אומרים שהבינה המלאכותית יכולה לשנות את חיינו. המילטון חושב שהיא בעצם כבר משנה אותם בפועל. "העוזרת האישית של גוגל, Siri (סירי) של אפל (Apple) ודומיהן לא נכתבו בידי אנשים והן מורצות ב-GPU. למעשה כל התוכניות שמשתמשות בזיהוי קולי, כולל Cortana (קורטנה), כולן מבצעות את זה בשבב הגרפי. לאפל ולמיקרוסופט (Microsoft) יש בסיסי נתונים גדולים שמלאים בשבבים גרפיים. ב-2006 טבעו את המונח GPGPU, או שבבים גרפיים לשימוש כללי, ועכשיו זה מגיע לעידן שזה סוף סוף קורה. אבל לא אפליקציית מפות שיודעת לתת הכוונה זה הדבר ששינה את חיינו. מה שעושה את זה הוא השימוש בלימוד מעמיק ובינה מלאכותית עבור שוק המכוניות האוטונומיות, לדוגמה. אי אפשר לבנות דבר כזה בעזרת קוד שמזהה כל פינת רחוב וכל ציון דרך כדי לנהוג כמו שצריך. למעשה לפני חמש שנים, כשהבינה המלאכותית הפכה לשימושית, גוגל בנתה מכונית אוטונומית ראשונה, והסיבה שגוגל הייתה הראשונה לעשות את זה היא שהיא יכלה להרשות לעצמה לקחת אלפי מתכנתים שיכתבו פקודות ‘אם אז’, וגם אז כל מה שהצליחו לעשות זה להפעיל אותה בקטע מצומצם של כביש מהיר, בצד אחד בלבד, והם לא הצליחו בעצם לסיים את העבודה. והיום יש כבר 200 חברות ויותר שעוסקות בתחום המכונית האוטונומית כי מספיק להיות חברת הזנק בת 10 אנשים שרוכשת מכונית משומשת ולשים בה מצלמה, חיישנים ושבב גרפי חזק שיעשה את העבודה ואתה בעניינים", הוא אמר.

אז השבבים שאתם בונים יותר חזקים ובעלי יותר יכולות מתמיד?

"לחלוטין. כל דור חדש שאנחנו בונים הוא הרבה יותר חזק. לדוגמה, התחום של המכונית בנהיגה עצמית. המערכת הראשונה שלנו נקראה Drive PX והיא יכלה לבצע מיליארד פעולות של למידה עמוקה בשנייה, והיא הייתה גדולה מאוד ותפסה את כל תא המטען של המכונית, והיא סיפקה עזרי נהיגה פשוטים למדי, כמו אם היא זיהתה אדם שעובר את הכביש היא לחצה על הבלם, או ששמרה שהמכונית תישאר בנתיב שלה. ברמה הבאה, שמכונה רמה שלוש או ארבע, אתה יכול להיכנס למכונית, אתה מקליד לאן אתה רוצה להגיע והמכונית נוסעת, כשאתה עדיין מאחורי ההגה מוכן לקחת שליטה במקרה חירום, ואת זה כבר אפשר לבצע עם מערכת שאנחנו מכנים Drive PX2 שבעצם מורכבת בעיקר מ-4 מעבדים גרפיים, שתי מערכות של שבב גדול ושבב קטן כדי לספק יתירות, וזו כבר מערכת שיכולה לבצע 20 מיליארד פעולות למידה בשנייה. הצעד הסופי יהיה מה שמכונה 'טקסי רובוט' שזו כבר באמת תהיה מכונית שתיסע לבד, אבל מצד שני הביצוע שלה אפילו יהיה קל יותר כי היא תיסע בתוך אזור מוגדר, במספר נתיבים שנקבעו מראש, וכדי לעבור לאזור אחר יהיה צורך לעבור מכונית. זה קצת יותר קל אפילו ממכונית לכל מטרה".

ואיפה אנחנו עומדים עכשיו?

"בשבוע שעבר הכרזנו על Drive PX Pegasus, שתהיה מבצעית כבר בשנה הבאה, וזו כבר מערכת שתספק לא פחות מ-320 מיליארד פעולות למידה חכמה בשנייה. אז עברנו מ-1 ל-20 ועכשיו ל-320 מיחיארד פעולות ותוך מספר שנים בלבד, ולאף אחד אחר בעולם אין מערכת כזו שהתקדמה כל כך".

התמקדות בהצלה

אבל ההיבט הטכני של מכוניות אוטונומיות והנהיגה העצמאית זה לא העיקר, הוא הסביר, מה שחשוב הוא שזה מציל חיים. "נהיגה אוטונומית יכולה למנוע תאונות דרכים, שזה הגורם השלישי באופן גלובלי למיתה בעולם. ויש עוד תחום חשוב זה רפואה, ובעיקר רדיולוגיה. בצילומי רנטגן, כולל כל הנגזרות, לפעמים יש צורך לחכות זמן ארוך מדי לפענוח, ויש כמובן גם הבדלים בין היכולות של הבודקים. ומה זה צילום רנטגן אם לא תמונה? אנחנו עובדים עם מספר אוניברסיטאות ועם חברות מובילות בתחום ההדמיה הרפואית כדי ליצור אלגוריתם שיזרז מאוד את הפענוח ויעזור באותם מקרים דחופים בהם הזמן הוא חשוב מאוד. זה כבר בפיתוח ואני מאמין שתוך כמה שנים זה ייכנס כבר לשימוש מול חולים אמיתיים. כך שבהחלט אפשר לומר שזה תרחיש בו הבינה המלאכותית תשפר את החיים שלנו, כמו נהיגה אוטונומית", אמר המילטון.

הכל מבוסס תמונה?

"למעשה אתה יכול בעצם להביא את הכל כתמונה. גל קול, גרף של טמפרטורות, הכל זה כמו תמונה עבור המחשב. זה אולי סוג של הפשטה, אבל כן אפשר לומר את זה, ובכל מקרה זו הדרך לבצע את תהליך הסקת המסקנות שנמצא בעצם בבסיס של למידה עמוקה, וזה אומר שכל מחשב בענן בעצם זקוק לפחות למעבד גרפי אחד כדי שהוא יכול לעשות את זה ולספק את היכולות שנדרשות כדי להכין את הבסיס לאפליקציות הנבנות על סמך הסקת המסקנות הללו, כמו תיוג בפייסבוק, מציאת תמונות זהות בגדלים אחרים בגוגל, וגם רכיב שמשלבים בקצה של טרקטור כדי לזהות עשבים שוטים בין גידולים לצורך טיפול ספציפי".

ויש גם את ההיבט של הטלפונים, כמו שאנחנו רואים לאחרונה מצד יצרניות רבות, אפל כמובן, קוואלקום (Qualcomm) ואחרות.

"הסיבה היא שככל שמקטינים את המעבדים יש זליגת אנרגיה גדולה יותר ובזבוז חשמל, ובכל מקרה מכיוון שכבר יצא למעשה הקיטור מחוק מור, המעבדים הראשיים עצמם אף פעם לא יהיו חזקים מספיק עבור שימושי בינה מלאכותית. הם יכולים אמנם לבצע במהירות כמה פקודות במקביל לגבי הפעלת המערכת, אבל הם לא יכולים לבצע את מליוני הפעולות שזקוקים להם בשנייה אחת כדי לזהות תמונה אחת של חתול. ניסיון לעשות את זה עם המעבד הראשי הוא פשוט לא יעיל מבחינה אנרגטית. גם במחשב זה כך. עבור חברה כמו פייסבוק בזבוז אנרגיה כזה פירושו הוצאה כספית מיותרת מאוד גדולה".

ההיבט של ה-IT

אבל לא רק מכוניות, מכונות הדמיה והענן נהנים מבינה מלאכותית, וגם לא רק ההיבטים של הצרכנים שמחפשים תמונות של חתולים או עוגות גבינה. לפי המילטון גם ה-IT המסורתי יכול ליהנות מאוד מהשימושים שמציעות הטכנולוגיות של עידן הבינה המלאכותית החדשה. "רוב החדרים שמכילים את שרתי בסיסי הנתונים מכילים הרבה אוויר וזו דרך מאוד לא יעילה להסיר חום. אם חם לך ואתה קופץ למים אתה מתקרר מהר כי מים מוליכים חום הרבה יותר טוב, בעשרות מונים. בעתיד אנחנו נוכל לשים בחדרים הללו שרתים שמבוססים על מעבדים גרפיים, ולמעשה אפילו להחליף הרבה מאוד שרתים בשרת אחד שמבוסס על מעבדים גרפיים ולחסוך הרבה מאוד הוצאות קירור, שזו הוצאה גדולה מאוד בחדרי שרתים. למעשה, אם ניקח לדוגמה את הצרכים של פייסבוק, במקום חדר שרתים שגודלו בערך שני מגרשי כדורגל ניתן יהיה להסתפק באחד שהוא בגודל של מסעדה ואפילו פחות. המערכת עדיין תצטרך את אותה עוצמת חשמל אבל הוצאות הקירור יהיו מזעריות, וניתן יהיה אפילו להשתמש בקירור מים שהוא כאמור אפקטיבי יותר", הוא אמר.

אתם מציעים התקנים ייעודיים?

"מה שאנחנו עושים, וזה חשוב לזכור, זה לא רק חומרה זה גם תוכנה. מעל לשבב הגרפי שלנו יש את מערכת הקוד CUDA שגם בנינו עבורה ספריות רבות, כולל למידה עמוקה לאפשור ההכשרה והאימון של המחשבים. אולי לא יצרנו את המערכות והשפות בהן משתמשות החברות הגדולות כדי לבצע את תהליכי הרשת המעמיקה שלהם, אבל הספריות שלנו משולבות בכל אחת מהן. אבל צריך לזכור גם שעצם העובדה שיש לך את המעבד, זה רק חצי מהקרב. זו הסיבה שהכנו התקנים בשם DLA שהם מאיצי למידה מעמיקה בהם משולבת מערכת ה-CUDA שלנו ואנו מציעים אותה למי שרוצה לפתח בתחום בתצורה של קוד פתוח, ואנחנו יכולים לזרז באופן משמעותי את הפיתוח בתחום".

ולמה כדאי לבחור את ההתקנים שלכם?

"אחת הסיבות שאנחנו מציעים את הטכנולוגיה שלנו כהתקן היא הקלות בה משלבים אותו בחדר השרתים. אם תנסה לבנות שרת חדש ולשב בו את כל ספריות הלמידה המעמיקה שצריך, וגם אם יש לך ניסיון, זה יכול לקחת יומיים, שבועיים ואולי כל החיים כי אחרי שבועיים אתה תתייאש. את ההתקן שלנו אתה פשוט מחבר, מתחבר לענן שלנו, מוריד עדכונים ומיטובים ואתה מוכן לעבוד".

מה האסטרטגיה העסקית שלכם רכישות של חברות או פיתוח עצמי?

"לרכוש חמש חברות הזנק שמייצרות כל אחת שבב אחר ולומר זו האסטרטגיה שלנו? זו לא אסטרטגיה, כי מה שיש בסופו של דבר זה חמש ארכיטקטורות שונות, ולא אחת שאתה יכול באמת להציע. האסטרטגיה שלנו תמיד הייתה ארכיטקטורה אחת למעבדים הגרפיים, עם עבודה מקבילה שיכולה להוסיף ערך. אנחנו עובדים מול הרבה חברות הזנק וגם משקיעים בחלקן, ואפילו מבצעים רכישות קטנות מדי פעם, אבל זו לא אסטרטגיה, וגם אז זה רק אם הן משתלבות בפלטפורמה שלנו. אנחנו מוציאים בכל שנה 2 מיליארד דולר על פיתוח, חצי בחומרה וחצי בתוכנה".

גרסה מקוצרת של הראיון הופיעה לראשונה בפורטל ה-IT של אנשים ומחשבים

קרדיט תמונה ראשית: צבי קצבורג